🚀 Benvenuti in un emozionante viaggio nell'universo del fine-tune di GPT-3! 🤖

Immaginate un mondo in cui l'Intelligenza Artificiale può scrivere con una creatività senza limiti, rispondendo alle vostre esigenze in modo sorprendente.

Oggi vi condurremo attraverso i segreti di questo affascinante processo e vi sveleremo come utilizzare Python per portare le vostre interazioni con questa meraviglia dell'IA a nuovi livelli epici. 🧠✨

Pronti a esplorare le profondità del fine-tune di GPT-3 e sbloccare il potenziale illimitato dell'Intelligenza Artificiale? Continuate a leggere per un'avventura che cambierà il modo in cui interagite con il mondo digitale! 🌟

Cosa è il Fine-Tune?

Il "fine-tune" è un'arte intrigante nel mondo del deep learning, un'approccio al transfer learning in cui i pesi di un modello preaddestrato vengono adattati per nuovi dati.

Questa pratica può coinvolgere l'intera rete neurale o solo un sottoinsieme dei suoi strati, congelando quelli che non subiscono ulteriori aggiornamenti durante la fase di backpropagation. Nel caso di architetture come le reti neurali convoluzionali, è comune mantenere congelati i primi strati, che catturano caratteristiche di basso livello, mentre i livelli successivi discernono caratteristiche di alto livello più correlate al compito per cui il modello è stato addestrato.

Il fine-tuning può essere effettuato in diverse modalità, dalla modifica di un sottoinsieme di strati all'affinamento dell'intero modello. La tecnica prevede l'uso dell'apprendimento supervisionato, ma può anche essere combinata con l'apprendimento per rinforzo basato su feedback umano per creare modelli di linguaggio altamente personalizzati.

Vantaggi del Fine-Tune: Un Mondo di Opportunità

Prima di immergerci nei dettagli, è importante comprendere i vantaggi che il fine-tune può offrire. Questa pratica permette di personalizzare GPT-3 in base alle esigenze specifiche del tuo progetto, trasformando un modello geniale in uno che comprende profondamente il tuo scopo. Immagina un assistente virtuale che conosce a fondo il tuo settore, risponde in modo impeccabile alle domande degli utenti e, soprattutto, lo fa con un tocco di autenticità.

Il fine-tuning può migliorare la robustezza di un modello in varie situazioni e distribuzioni di dati, consentendo di adattarlo alle esigenze specifiche del tuo caso d'uso. Anche se il processo può risultare più oneroso dal punto di vista computazionale, l'investimento spesso si ripaga in termini di prestazioni superiori.

Inoltre, nuove varianti di fine-tuning, come l'adattamento a basso rango (LoRA), stanno emergendo come tecniche altamente efficienti per ottimizzare i modelli. Queste varianti aprono nuove opportunità per ottenere prestazioni simili a quelle del fine-tuning completo con minori requisiti di spazio.

Il fine-tuning è particolarmente diffuso nell'elaborazione del linguaggio naturale (NLP), dove grandi modelli di linguaggio possono essere personalizzati per compiti specifici, migliorando notevolmente le prestazioni rispetto ai modelli preaddestrati standard. Anche in ambito commerciale, alcune API offrono opportunità di fine-tuning, aprendo nuove strade per l'adattamento dei modelli alle esigenze specifiche.

Conoscere le possibilità del fine-tuning apre nuove prospettive per ottenere il massimo da GPT-3 e altri modelli di intelligenza artificiale, arricchendo il tuo approccio alla personalizzazione di queste potenti risorse.

E ora, il palcoscenico è pronto!

Come fare il fine-tune di GPT-3 utilizzando Python per migliorare le prestazioni

Ecco cosa useremo per questa avventura:

L'API OpenAI 🤖: Il nostro biglietto d'ingresso nell'universo di GPT-3.

Python 🐍: La nostra bacchetta magica per orchestrare il fine-tune.

Seguendo i passaggi che delineeremo, avrete tutto il necessario per intraprendere il vostro viaggio di messa a punto:

Ottieni la chiave API OpenAI

Creare i dati di addestramento

Controllare i dati di allenamento

Carica i dati di allenamento

Perfezionamento del modello

Controllare l'avanzamento della messa a punto

Salva il modello ottimizzato

Testare il nuovo modello a un nuovo prompt

Questa guida ti accompagnerà passo dopo passo nel processo di messa a punto di GPT-3, mostrato attraverso un notebook Jupyter. Se preferisci esplorare l'arte della messa a punto direttamente nel tuo terminale, OpenAI ha un'ottima guida per te.

Così, con un tocco di eleganza e la giusta dose di creatività, sarete pronti per svelare il potenziale magico di GPT-3. Pronti a iniziare il vostro viaggio? Buon apprendimento!

1. Ottieni la chiave API OpenAI

Prima di procedere e mettere a punto un modello, otteniamo le credenziali OpenAI necessarie per le chiamate API.

Vai su https://beta.openai.com/ , accedi e fai clic sul tuo avatar e Visualizza chiavi API :

Quindi crea una nuova chiave segreta e salvala per la richiesta:

Ora abbiamo le credenziali necessarie per effettuare una richiesta API.

2. Creare i dati di addestramento

Il secondo passo in questa affascinante avventura è la creazione dei dati di addestramento che guideranno GPT-3 a comprendere ciò che desideri comunicare. Questi dati devono essere formattati in un documento JSONL, ognuno contenente un nuovo prompt e la risposta ideale che desideri ottenere da GPT-3. Per iniziare, dovrai importare le librerie necessarie, come mostrato di seguito:

import json

import openai

Dopodiché, è fondamentale aggiungere la chiave API che hai ottenuto nel passaggio precedente:

api_key = "YOUR_OPENAI_API_KEY"

openai.api_key = api_key

Ora, avvia il processo di creazione dei dati di addestramento. In questa guida, prenderemo in considerazione alcune domande di supporto che sono state recentemente ricevute. Ad esempio:

training_data = [

{

"prompt": "Where is the billing ->",

"completion": " You find the billing in the left-hand side menu.\n"

},

{

"prompt": "How do I upgrade my account ->",

"completion": " Visit your user settings in the left-hand side menu, then click the 'upgrade account' button at the top.\n"

}

]

È importante notare che ogni prompt dovrebbe terminare con un suffisso, come ->, come suggerito nella documentazione API OpenAI.

Assicurati che ciascuna completion termini con un suffisso adeguato; nell'esempio sopra, abbiamo utilizzato .\n per segnalare una nuova riga.

Una volta che hai preparato i dati di addestramento sotto forma di un dizionario, il passo successivo è convertirli in un file JSONL corretto. Un file JSONL è essenzialmente un file JSON delimitato da nuove righe, quindi è necessario aggiungere un \n alla fine di ciascun oggetto, come illustrato di seguito:

file_name = "training_data.jsonl"with open(file_name, "w") as output_file:

for entry in training_data:

json.dump(entry, output_file)

output_file.write("\n")

Una volta completata questa fase, avrai i tuoi dati di addestramento pronti sotto forma di un file JSONL. Tuttavia, prima di procedere con la messa a punto, è fondamentale effettuare un controllo accurato sui dati di addestramento per assicurarti che siano pronti per plasmare GPT-3 nella direzione desiderata.

3. Controllare i dati di allenamento

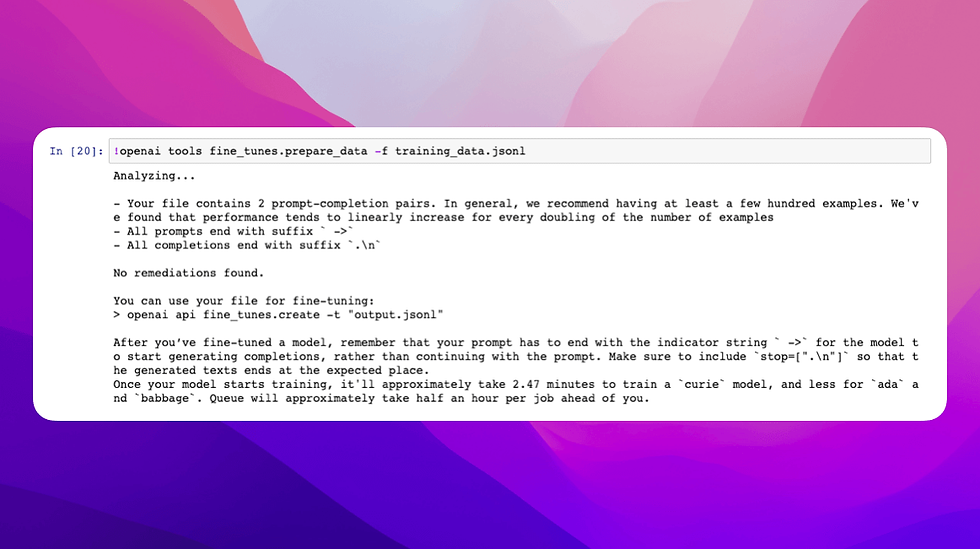

Una fase cruciale in questo percorso di fine-tuning è il controllo dei dati di addestramento. OpenAI mette a disposizione uno strumento di preparazione dei dati CLI che può essere un prezioso alleato in questa fase. Questo strumento fornisce preziosi suggerimenti su come riformattare i dati di addestramento per ottenere risultati ottimali.

Per provare questo strumento con i nostri dati di allenamento, esegui questa riga nel tuo notebook Jupyter:

!openai tools fine_tunes.prepare_data -f training_data.jsonl

Al termine di questa operazione, riceverai suggerimenti simili a quelli riportati di seguito:

Sebbene in questa guida useremo solo alcuni dei suggerimenti, è importante notare che tali raccomandazioni spesso richiedono almeno alcune centinaia di esempi per ottenere risultati ottimali.

Il tempo stimato varierà in base al numero di lavori in coda.

Dopo aver ricevuto i suggerimenti, saremo pronti per procedere con il caricamento dei dati di addestramento nella prossima sezione.

4. Caricamento dei Dati di Addestramento

Ora che hai ottenuto preziosi suggerimenti per migliorare i dati di addestramento, è il momento di caricare i dati su OpenAI. Per farlo, segui questi passaggi:

upload_response = openai.File.create(

file=open(file_name, "rb"),

purpose='fine-tune'

)

file_id = upload_response.id

upload_response

Esaminando la risposta, individuerai il file id, un elemento chiave che ci servirà nel prossimo passo, quando inizieremo il processo di messa a punto del modello.

Questi passaggi preliminari ci preparano per il viaggio nel mondo affascinante del fine-tuning, dove modelleremo GPT-3 per rispondere alle domande comuni relative al supporto in modo corretto e personalizzato. Siamo pronti per la prossima tappa

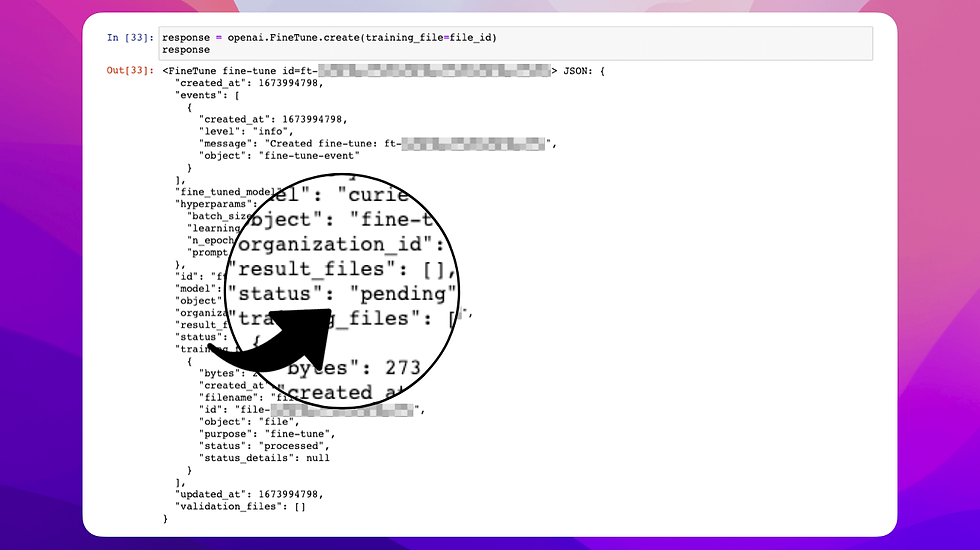

5. Perfezionamento del modello

Dopo aver diligentemente preparato i dati di addestramento e li abbiamo caricati con cura, giunge il momento tanto atteso per dare vita al processo di perfezionamento del modello.

Per dare il via a questa avventura, esegui il seguente comando:

fine_tune_response = openai.FineTune.create(training_file=file_id)

fine_tune_response

Il modello predefinito per questa fase è Curie, ma se desideri utilizzare DaVinci come modello base per affinamento, puoi farlo in questo modo:

openai.FineTune.create(training_file=file_id, model="davinci")

La prima risposta che riceverai sarà simile a questa:

6. Controllare l'avanzamento della messa a punto

Per garantire il successo del processo di fine-tuning, è essenziale monitorarne costantemente l'avanzamento. Hai a disposizione due opzioni per farlo:

Opzione 1: Elenca gli Eventi

Puoi utilizzare la funzione openai.FineTune.list_events() e fornire l'ID di fine_tune_response per elencare tutti gli eventi attuali. In questo modo, otterrai un dettagliato elenco degli eventi relativi al tuo lavoro di fine-tuning:

fine_tune_events = openai.FineTune.list_events(id=fine_tune_response.id)

Opzione 2: Recupera il Lavoro di Fine-Tuning

Un'altra possibilità è utilizzare openai.FineTune.retrieve(id=fine_tune_response.id) per recuperare informazioni specifiche su un particolare lavoro di fine-tuning. Questo ti fornirà un oggetto JSON dettagliato con tutte le informazioni necessarie:

retrieve_response = openai.FineTune.retrieve(id=fine_tune_response.id)

Una volta che il tuo lavoro di fine-tuning è in corso, potrai monitorare l'evento di fine-tuning e osservare con entusiasmo come il modello si trasforma e si adatta alle tue esigenze specifiche.

Il percorso verso un modello GPT-3 personalizzato e altamente performante è ormai iniziato. Continua a seguire con attenzione, poiché stiamo per raggiungere vette di eccellenza!

7. Salva il modello ottimizzato

Il percorso per ottenere un modello GPT-3 ottimizzato sta giungendo alla sua fase di completamento, ma ci sono ancora alcuni dettagli importanti da affrontare, tra cui la risoluzione di un problema potenziale.

Durante il processo di ottimizzazione, la chiave fine_tuned_model potrebbe non essere immediatamente disponibile nell'oggetto fine_tune_response restituito da openai.FineTune.create(). Non c'è bisogno di preoccuparsi, perché puoi facilmente superare questo ostacolo.

Per verificare lo stato del processo di ottimizzazione, puoi richiamare la funzione openai.FineTune.retrieve() e passare fine_tune_response.id. Questa funzione restituirà un oggetto JSON con preziose informazioni sullo stato dell'addestramento, inclusi dettagli come l'epoca corrente, il batch corrente, la perdita di addestramento e la perdita di convalida.

Una volta che il processo di messa a punto è stato portato a termine con successo, è possibile controllare lo stato di tutti i modelli ottimizzati chiamando openai.FineTune.list(). Questa operazione elencherà tutti i modelli ottimizzati e il loro stato attuale.

Una volta raggiunto il traguardo e il processo di fine-tuning è completato, puoi finalmente accedere alla chiave fine_tuned_model. Per farlo, chiamerai nuovamente la funzione openai.FineTune.retrieve() e passerai fine_tune_response.id. Questo ti restituirà un oggetto JSON con la chiave fine_tuned_model e l'ID del modello ottimizzato che potrai utilizzare per completamenti futuri.

Quando hai ottenuto la chiave fine_tuned_model, puoi procedere a salvare il nome del modello ottimizzato utilizzando uno dei seguenti metodi:

Opzione 1 (Se response.fine_tuned_model non è nullo):

fine_tuned_model = fine_tune_response.fine_tuned_model

fine_tuned_model

Opzione 2 (Se response.fine_tuned_model è nullo):

retrieve_response = openai.FineTune.retrieve(fine_tune_response.id)

fine_tuned_model = retrieve_response.fine_tuned_model

fine_tuned_model

Apparirà qualcosa del genere:

8. Testare il nuovo modello a un nuovo prompt

Siamo giunti alla fase conclusiva, dove testeremo il nostro modello GPT-3 ottimizzato su un prompt fresco di zecca.

Tenendo presente che la messa a punto è stata effettuata solo su due prompt, non ci aspettiamo un livello di completamento estremamente accurato. Quindi, prepariamoci per il test.

Inizia creando un nuovo prompt, assicurandoti di terminarlo con lo stesso suffisso utilizzato nei dati di addestramento, ovvero ->:

new_prompt = "How do I find my billing? ->"Successivamente, esegui il completamento utilizzando il tuo modello ottimizzato:

answer = openai.Completion.create(

model=fine_tuned_model,

prompt=new_prompt,

max_tokens=100,

temperature=0

)

answer['choices'][0]['text']

Ecco cosa ho ottenuto:

Ottimo! Ora hai a disposizione un modello GPT-3 ottimizzato pronto ad affrontare le sfide future con grande maestria.

Questo è solo l'inizio delle tue avventure nell'utilizzo di un modello personalizzato e altamente performante. Continua a sperimentare e a esplorare le infinite possibilità che il fine-tuning ha da offrire. Buon lavoro!

In Sintesi: Come fare il fine-tune di GPT-3

Ecco un riepilogo affascinante del nostro viaggio:

Abbiamo ottenuto la nostra preziosa chiave API OpenAI.

Creato dati di addestramento su misura per il nostro scopo.

Controllato attentamente e migliorato i nostri dati di addestramento.

Con determinazione, abbiamo caricato i dati di addestramento nella piattaforma OpenAI.

Attraverso l'arte del fine-tuning, abbiamo perfezionato un modello GPT-3 secondo le nostre esigenze.

Abbiamo seguito da vicino l'evoluzione del nostro processo di messa a punto.

Con grande soddisfazione, abbiamo salvato il modello ottimizzato pronto per l'azione.

Con il cuore pieno di aspettative, abbiamo testato il nuovo modello su un prompt fresco di zecca.

Continua a Sognare in Grande: Miglioramenti Futuri

Ma il nostro viaggio non si ferma qui. L'analisi dei dati di addestramento di OpenAI nel passaggio 2 di questa guida ci suggerisce di espandere ulteriormente la quantità di dati di addestramento.

Mentre ho utilizzato solo 2 suggerimenti in questa guida, il consiglio è di avere almeno alcune centinaia di esempi/suggerimenti per massimizzare l'efficacia.

Inoltre, è importante considerare che le domande frequenti potrebbero non essere sempre il miglior caso d'uso per l'ottimizzazione. Se desideri automatizzare le risposte alle domande dei tuoi utenti, potresti scoprire che un approccio basato su risposte alle domande è più adatto rispetto alla messa a punto di un modello GPT-3.

Hai bisogno di soluzioni AI su misura? Siamo Qui per Te!

Hai bisogno di assistenza per perfezionare il tuo modello GPT-3 o hai altre domande che stuzzicano la tua curiosità? Non esitare a contattarci ➡️ Mandaci una email 🤖

Siamo qui per te, pronti ad offrire la nostra expertise e la nostra passione per l'Intelligenza Artificiale. Abbiamo il know-how per affrontare le sfide più complesse e per trovare la soluzione perfetta.

Il futuro è promettente, e il nostro impegno è quello di aiutarti a raggiungere ogni obiettivo che ti prefiggi.

.png)

Comments