Cos'è la Quantizzazione degli LLM: Ridurre la Complessità dei Modelli Linguistici

- Team I.A. Italia

- 28 mag 2024

- Tempo di lettura: 10 min

Immagina di avere un potente supercomputer in grado di risolvere problemi complessi in pochi secondi, ma che occupa l'intero spazio del tuo soggiorno e consuma energia pari a quella di una piccola città. Ora, pensa a quanto sarebbe fantastico avere lo stesso potere computazionale in un dispositivo grande quanto un libro e che consuma meno energia di una lampadina. Questo è, in sostanza, ciò che la quantizzazione degli LLM (Large Language Models) promette di fare per il mondo dell'intelligenza artificiale.

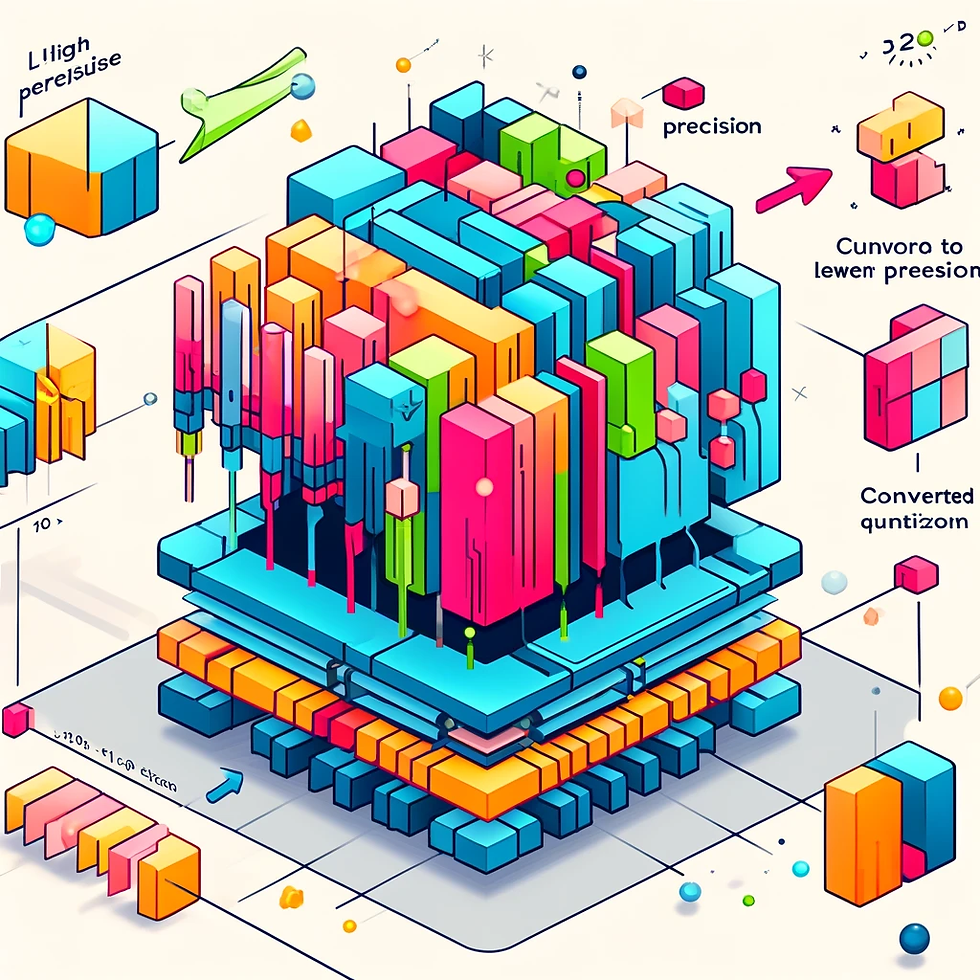

La quantizzazione è un processo che permette di ridurre la precisione dei modelli , convertendo i pesi del modello da una precisione più alta, come 32 bit, a una precisione inferiore, come 8 bit o addirittura 4 bit. Questo processo riduce drasticamente le dimensioni del modello e i requisiti di calcolo, rendendo possibile l'esecuzione di complessi modelli linguistici su hardware più modesti senza perdere significativamente in accuratezza.

Ma perché è importante? Con l'aumento esponenziale della dimensione dei modelli linguistici e dei loro requisiti computazionali, la quantizzazione diventa essenziale per renderli accessibili e utilizzabili in contesti più ampi, dai dispositivi mobili alle applicazioni industriali. In questo articolo, esploreremo i dettagli di come funziona la quantizzazione, le tecniche utilizzate, e i benefici che può apportare. Indice

Cos'è la Quantizzazione?

Come Funziona la Quantizzazione degli LLM

Benefici della Quantizzazione

Tecniche di Quantizzazione Comuni

Esempi Pratici di Quantizzazione

Sfide e Limitazioni

Strumenti per la Quantizzazione

Cos'è la Quantizzazione degli LLM?

La quantizzazione degli LLM (Large Language Models) è una tecnica che mira a ridurre la precisione numerica dei pesi e delle attivazioni dei modelli, convertendo dati da formati ad alta precisione come i 32-bit float a formati a bassa precisione come 8-bit o 4-bit. Questo processo riduce significativamente la dimensione dei modelli, migliorando l'efficienza dell'inferenza e riducendo i requisiti di memoria e calcolo.

Come Funziona in breve ?

La quantizzazione implica la riduzione della precisione dei numeri utilizzati per rappresentare i pesi e le attivazioni nel modello. Esistono principalmente due approcci:

Quantizzazione Post-Addestramento (PTQ): Avviene dopo l'addestramento del modello e può essere implementata rapidamente ma con una possibile perdita di accuratezza.

Quantizzazione Consapevole dell'Addestramento (QAT): Integra la quantizzazione durante l'addestramento del modello, ottenendo solitamente risultati più accurati ma richiedendo maggiori risorse computazionali.

Tecniche di Quantizzazione

GPTQ (Generative Pretrained Transformer Quantization): Un approccio che combina la quantizzazione post-addestramento con specifiche ottimizzazioni per mantenere l'accuratezza del modello, anche quando viene compresso in formati a bassa precisione.

Bitsandbytes: Una libreria che facilita la quantizzazione di modelli in 8-bit e 4-bit, offrendo un buon compromesso tra efficienza e precisione.

AWQ (Activation-aware Weight Quantization): Si concentra sulla quantizzazione dei pesi e delle attivazioni, migliorando il throughput delle operazioni dense e self-attention.

Come Funziona la Quantizzazione degli LLM nel Dettaglio

Ecco come funziona in dettaglio:

Riduzione della Precisione: La quantizzazione converte i valori di peso e attivazione del modello da una rappresentazione ad alta precisione, come il floating-point a 32 bit, a una rappresentazione a bassa precisione, come gli interi a 8 o 4 bit. Questo processo mappa un intervallo continuo di valori floating-point a un insieme discreto di livelli, riducendo così il numero di bit necessari per rappresentare ciascun valore.

Tecniche di Quantizzazione:

Quantizzazione Post-Addestramento (PTQ): Questa tecnica applica la quantizzazione dopo che il modello è stato completamente addestrato. È relativamente semplice da implementare e non richiede dati di addestramento aggiuntivi. Tuttavia, può comportare una leggera perdita di accuratezza poiché la precisione dei pesi viene ridotta senza considerare l'impatto sul modello.

Addestramento Consapevole della Quantizzazione (QAT): Integra il processo di quantizzazione durante la fase di addestramento del modello. Questo metodo comporta una calibrazione continua dei pesi a bassa precisione durante l'addestramento, garantendo una maggiore accuratezza rispetto alla PTQ, ma richiede più risorse computazionali.

Gestione degli Outliers: Un problema comune nella quantizzazione è la presenza di valori anomali (outliers) che possono distorcere la scala e ridurre l'efficacia della quantizzazione. Per mitigare questo problema, i pesi possono essere divisi in blocchi più piccoli (ad esempio, gruppi di 64 o 128 pesi), e ogni blocco viene quantizzato separatamente. Questo approccio migliora la precisione complessiva del modello quantizzato.

Utilizzo di Diverse Tecniche e Strumenti:

GPTQ (Quantizzazione Post-Addestramento per GPT): Una tecnica che combina la famiglia di modelli GPT con la quantizzazione post-addestramento, ottimizzando la compressione senza compromettere troppo l'accuratezza.

Bitsandbytes: Una libreria che consente la quantizzazione a 4 bit, utilizzando formati di precisione come NF4 (Normalized Float 4) per migliorare la rappresentazione dei pesi quantizzati e ridurre ulteriormente la memoria necessaria.

llama.cpp: Una libreria C++ che permette l'inferenza su modelli LLaMA quantizzati, ottimizzata per l'aritmetica a bassa precisione su CPU, riducendo significativamente il carico computazionale.

Benefici della Quantizzazione degli LLM

La quantizzazione degli LLM (Large Language Models) offre numerosi vantaggi significativi, rendendo questa tecnica particolarmente utile per migliorare l'efficienza e la scalabilità dei modelli.

Riduzione delle Dimensioni del Modello: Uno dei benefici principali della quantizzazione è la riduzione delle dimensioni del modello. Convertendo i pesi e le attivazioni da rappresentazioni ad alta precisione (come i float a 32 bit) a rappresentazioni a bassa precisione (come gli interi a 8 o 4 bit), il modello diventa significativamente più piccolo. Questo permette di risparmiare spazio di archiviazione e rende possibile l'esecuzione di LLM su dispositivi con capacità hardware limitate, come smartphone e dispositivi IoT .

Aumento della Velocità di Inferenza: La quantizzazione riduce il carico computazionale richiesto per eseguire un modello. I bit ridotti comportano minori operazioni di calcolo e trasferimenti di memoria più efficienti, aumentando così la velocità di inferenza. Questo è particolarmente utile per applicazioni in tempo reale dove la latenza deve essere minima .

Efficienza Energetica: Modelli quantizzati consumano meno energia rispetto ai loro equivalenti ad alta precisione. Questo beneficio è cruciale per implementazioni su larga scala e per dispositivi alimentati a batteria, contribuendo a prolungare la durata della batteria e a ridurre i costi operativi complessivi.

Scalabilità Migliorata: La riduzione della memoria necessaria consente una maggiore scalabilità. Le organizzazioni possono distribuire più modelli o gestire carichi di lavoro più elevati senza dover investire in hardware aggiuntivo costoso. Questo rende la quantizzazione una soluzione praticabile per le imprese che desiderano espandere l'uso di LLM senza incorrere in costi proibitivi.

Supporto per Inferenze su Larga Scala: La quantizzazione permette di eseguire inferenze su larga scala, poiché i modelli più piccoli possono essere distribuiti più facilmente attraverso infrastrutture esistenti, riducendo la necessità di aggiornamenti hardware. Questo è particolarmente vantaggioso per servizi cloud e applicazioni aziendali su vasta scala.

Nonostante questi benefici, è importante considerare anche i potenziali svantaggi della quantizzazione, come la possibile perdita di accuratezza. Tuttavia, tecniche avanzate come la Quantization-Aware Training (QAT) possono aiutare a mitigare questi problemi, garantendo che i modelli quantizzati mantengano un'elevata qualità predittiva .

Tecniche di Quantizzazione Comuni degl LLM

La quantizzazione degli LLM (Large Language Models) può essere implementata attraverso diverse tecniche, ciascuna con i propri vantaggi e applicazioni specifiche. Ecco alcune delle tecniche di quantizzazione più comuni:

Quantizzazione Post-Addestramento (PTQ): Questa tecnica viene applicata dopo che il modello è stato completamente addestrato. PTQ è semplice da implementare e non richiede dati di addestramento aggiuntivi. Tuttavia, potrebbe comportare una perdita di accuratezza poiché la precisione dei pesi viene ridotta senza considerare l'impatto sul modello durante l'addestramento

Quantizzazione Consapevole dell'Addestramento (QAT): A differenza della PTQ, la QAT incorpora la quantizzazione durante la fase di addestramento del modello. Questo metodo utilizza moduli di "quantizzazione e de-quantizzazione" (Q/DQ) durante l'addestramento per simulare il comportamento della quantizzazione durante l'inferenza. La QAT permette al modello di adattarsi meglio ai calcoli a bassa precisione, risultando in una maggiore accuratezza complessiva

Quantizzazione a Blocchi: Per migliorare la precisione e gestire gli outlier, i pesi possono essere suddivisi in blocchi di dimensioni più piccole, come 64 o 128 pesi per blocco. Ogni blocco viene quantizzato separatamente, mitigando l'effetto degli outlier e migliorando la precisione complessiva del modello

Quantizzazione Ibrida: Questa tecnica combina la quantizzazione a bassa precisione (es. INT8) con rappresentazioni a precisione più alta (es. FP16 o FP32) per parti specifiche del modello. Ad esempio, le sequenze di operatori sensibili alla quantizzazione possono essere mantenute in FP16 per evitare significative perdite di accuratezza

Quantizzazione GPTQ (Generative Pre-trained Transformer Quantization): GPTQ è una tecnica di quantizzazione post-addestramento specificamente ottimizzata per i trasformatori. Utilizza metodi come la decomposizione di Cholesky per garantire la stabilità numerica e l'aggiornamento dei pesi in batch per migliorare l'efficienza. GPTQ è particolarmente efficace nel ridurre i requisiti computazionali e di memoria dei grandi modelli linguistici senza compromettere significativamente le prestazioni

Quantizzazione NF4 (Normalized Float 4-bit): Utilizzata principalmente da metodi come QLoRA, NF4 normalizza ogni peso a un valore tra -1 e 1 per una rappresentazione più accurata dei valori a bassa precisione. Questa tecnica permette di memorizzare i pesi quantizzati a 4 bit, riducendo ulteriormente i requisiti di memoria

Ogni tecnica di quantizzazione offre un equilibrio tra efficienza e accuratezza, e la scelta della tecnica più adatta dipende dalle specifiche esigenze applicative e dai vincoli hardware. Implementare la quantizzazione correttamente può portare a modelli più leggeri, veloci ed efficienti dal punto di vista energetico, consentendo l'uso di LLM anche in contesti con risorse limitate.

Esempi Pratici di Quantizzazione di un LLM con Python e Hugging Face

La quantizzazione degli LLM con Python e Hugging Face è un processo che permette di ridurre le dimensioni e i requisiti computazionali dei modelli mantenendo una buona performance. Ecco un esempio pratico di come eseguire la quantizzazione utilizzando la libreria transformers di Hugging Face.

Installazione delle Librerie Necessarie: Per prima cosa, bisogna installare le librerie necessarie, tra cui transformers, bitsandbytes, e auto-gptq. Questo può essere fatto tramite pip:

pip install transformers bitsandbytes auto-gptqCaricamento del Modello e Tokenizzatore: Successivamente, si carica il modello pre-addestrato e il tokenizzatore. In questo esempio, utilizziamo il modello Mistral-7B:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_id = "mistralai/Mistral-7B-v0.1"

tokenizer = AutoTokenizer.from_pretrained(model_id)

Configurazione della Quantizzazione: La configurazione della quantizzazione viene definita utilizzando GPTQConfig, dove si specifica il numero di bit per la quantizzazione, il dataset per la calibrazione e altre impostazioni rilevanti:

from transformers import GPTQConfig

quantization_config = GPTQConfig(

bits=4,

group_size=128,

dataset="ptb"

)

Caricamento del Modello Quantizzato: Utilizzando la configurazione di quantizzazione, si carica il modello specificando la mappa dei dispositivi e altre impostazioni per l'inferenza:

model = AutoModelForCausalLM.from_pretrained(

model_id,

quantization_config=quantization_config,

device_map="auto"

)

Preparazione del Testo di Input: Il testo di input viene tokenizzato e preparato per l'inferenza:

inputs = tokenizer("Cosa è la quantizzazione degli LLM?", return_tensors="pt").to("cuda")Generazione del Testo: Infine, si esegue la generazione del testo utilizzando il modello quantizzato:

outputs = model.generate(**inputs)

generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(generated_text)In questo esempio, il modello viene caricato e configurato per eseguire inferenze su un dispositivo GPU, utilizzando la quantizzazione a 4 bit per ridurre il consumo di memoria e migliorare la velocità di esecuzione. La quantizzazione a 4 bit è particolarmente utile per eseguire modelli di grandi dimensioni su hardware con risorse limitate, mantenendo al contempo una buona accuratezza delle previsioni.

Questo processo permette di sfruttare modelli avanzati come quelli di Hugging Face in applicazioni pratiche senza dover disporre di infrastrutture computazionali costose, rendendo l'IA più accessibile e utilizzabile in vari contesti.

Sfide e Limitazioni della Quantizzazione degli LLM

La quantizzazione degli LLM (Large Language Models) presenta numerose sfide e limitazioni che devono essere attentamente considerate per garantire prestazioni ottimali. Ecco alcune delle principali difficoltà associate a questa tecnica:

Perdita di Accuratezza: Una delle principali sfide della quantizzazione è la perdita di precisione. Riducendo i bit necessari per rappresentare i pesi e le attivazioni, si introduce inevitabilmente un certo grado di errore. Questo può portare a una diminuzione delle prestazioni del modello, specialmente quando si utilizzano tecniche di quantizzazione più aggressive, come la quantizzazione a 4 o 2 bit

Gestione degli Outliers: I valori anomali (outliers) possono avere un impatto sproporzionato sulla precisione della quantizzazione. Per mitigare questo problema, spesso si utilizzano tecniche come la quantizzazione a blocchi, dove i pesi sono suddivisi in gruppi più piccoli e quantizzati separatamente. Tuttavia, questa soluzione richiede una gestione aggiuntiva dei fattori di scala per ogni blocco, aumentando la complessità del processo

Efficienza Computazionale e Risorse di Memoria: Anche se la quantizzazione riduce le dimensioni del modello, l'efficienza computazionale può essere influenzata negativamente durante l'inferenza. Ad esempio, le tecniche di quantizzazione dinamica richiedono de-quantizzazione in tempo reale, aumentando il carico computazionale. Inoltre, la memoria necessaria per gestire le operazioni intermedie può limitare i benefici della quantizzazione, specialmente su hardware con risorse limitate

Complessità del Processo di Inferenza: La quantizzazione può complicare il processo di inferenza, rendendo difficile mantenere la velocità e l'efficienza. Ad esempio, tecniche come la ricerca beam e il campionamento, utilizzate per generare testo in modo autoregressivo, aumentano significativamente il carico computazionale e possono rallentare il tempo di risposta, cruciali per applicazioni in tempo reale

Problemi di Parallelizzazione: L'implementazione di kernel CUDA per ottimizzare l'inferenza su GPU può essere complessa e richiedere aggiornamenti frequenti per tenere il passo con i progressi della ricerca. Inoltre, il Global Interpreter Lock (GIL) di Python limita l'esecuzione parallela di più thread, riducendo l'efficacia della parallelizzazione e aumentando i costi computazionali

Imprevedibilità delle Lunghezze dei Prompt: La variabilità delle lunghezze dei prompt introduce sfide significative nell'allocazione della memoria e nell'efficienza computazionale. I prompt più lunghi richiedono più risorse, rallentando l'inferenza, mentre i prompt più brevi possono portare a un sottoutilizzo delle risorse allocate, aumentando i costi operativi e riducendo l'efficienza complessiva

Affrontare queste sfide richiede un'attenta ottimizzazione e un bilanciamento tra efficienza e accuratezza, utilizzando tecniche avanzate e personalizzate di quantizzazione per adattarsi alle specifiche esigenze delle applicazioni reali.

Strumenti per la Quantizzazione degli LLM in Python

La quantizzazione degli LLM (Large Language Models) può essere gestita con vari strumenti disponibili nell'ecosistema Python. Questi strumenti permettono di ridurre la dimensione dei modelli e i requisiti computazionali senza comprometterne troppo le prestazioni. Ecco alcuni degli strumenti più rilevanti e utili per la quantizzazione degli LLM:

Transformers e AutoGPTQ di Hugging Face: La libreria transformers di Hugging Face, insieme a AutoGPTQ, fornisce un'API semplice per applicare la quantizzazione GPTQ su modelli linguistici. Questa combinazione consente di quantizzare modelli a 8, 4, 3 o addirittura 2 bit, mantenendo elevate prestazioni e velocità di inferenza. Per usare AutoGPTQ, è necessario installare le librerie richieste e configurare il quantizzatore con il numero di bit e il dataset di calibrazione

Bitsandbytes: La libreria bitsandbytes, sviluppata da Tim Dettmers, è progettata per rendere accessibili le tecniche di quantizzazione avanzate. bitsandbytes supporta la quantizzazione a basso bit come LLM.int8() e QLoRA (Quantized Low-Rank Adaptation), che consente di ridurre significativamente la memoria necessaria per il fine-tuning dei modelli su hardware di consumo mantenendo prestazioni comparabili a modelli a 16 bit

LLM-QBench e llmc: LLM-QBench è uno strumento efficiente per la compressione degli LLM, che supporta vari metodi di compressione avanzata e backend di inferenza multipli. Utilizzando LLM-QBench, è possibile scegliere tra diverse configurazioni di quantizzazione e calibrazione per ottimizzare il modello per specifici scenari di utilizzo. Questo strumento è particolarmente utile per applicare sequenzialmente più algoritmi di compressione su un LLM

AWQ (Activation-aware Weight Quantization): AWQ è una tecnica di quantizzazione che preserva una piccola percentuale di pesi critici per ridurre la perdita di precisione, permettendo l'esecuzione di modelli in precisione a 4 bit senza significative degradazioni delle prestazioni. AWQ è integrato nativamente in Hugging Face Transformers, consentendo di caricare modelli quantizzati direttamente dal Hub o di quantizzare i propri modelli

TensorRT di NVIDIA: TensorRT è un framework di ottimizzazione delle inferenze che include supporto per la quantizzazione. Utilizzando TensorRT, è possibile eseguire modelli quantizzati con alte prestazioni su GPU NVIDIA, ottimizzando ulteriormente l'efficienza computazionale e riducendo i tempi di inferenza

Questi strumenti offrono una gamma di opzioni per ottimizzare e distribuire modelli di grandi dimensioni in maniera più efficiente, rendendoli accessibili anche su hardware con risorse limitate.

Conclusione su Cos'è la Quantizzazione degli LLM: Ridurre la Complessità dei Modelli Linguistici

La quantizzazione degli LLM è una tecnica potente che permette di ridurre le dimensioni dei modelli e aumentare l'efficienza computazionale, rendendo possibile l'esecuzione di modelli complessi su hardware con risorse limitate. Tuttavia, come abbiamo visto, questa tecnica presenta anche sfide significative, tra cui la perdita di accuratezza, la gestione degli outliers, e la complessità del processo di inferenza.

Implementare la quantizzazione richiede un bilanciamento attento tra efficienza e precisione, utilizzando tecniche avanzate e personalizzate per adattarsi alle specifiche esigenze delle applicazioni reali. La scelta della tecnica di quantizzazione giusta e l'ottimizzazione continua sono cruciali per sfruttare appieno i vantaggi offerti da questa metodologia.

.png)

Comments